Google AI Overviews : quand les résumés IA deviennent dangereux

vendredi 4 juillet 2025 à 11:00

Co-fondatrice de Pinstrap. J’aime les pixels bien placés, les mots bien sentis, et les concepts qui laissent une trace (dans la tête, pas dans l’atmosphère). Dotée d'un humour indéniablement violent, je vulgarise les sujets complexes pour que chacun, même le plus éclaté, comprenne les sujets relatifs à la com'/ marketing/ design/ tech etc. En gros je vous facilite la vie et vos projets de fac ou d'école de commerce.

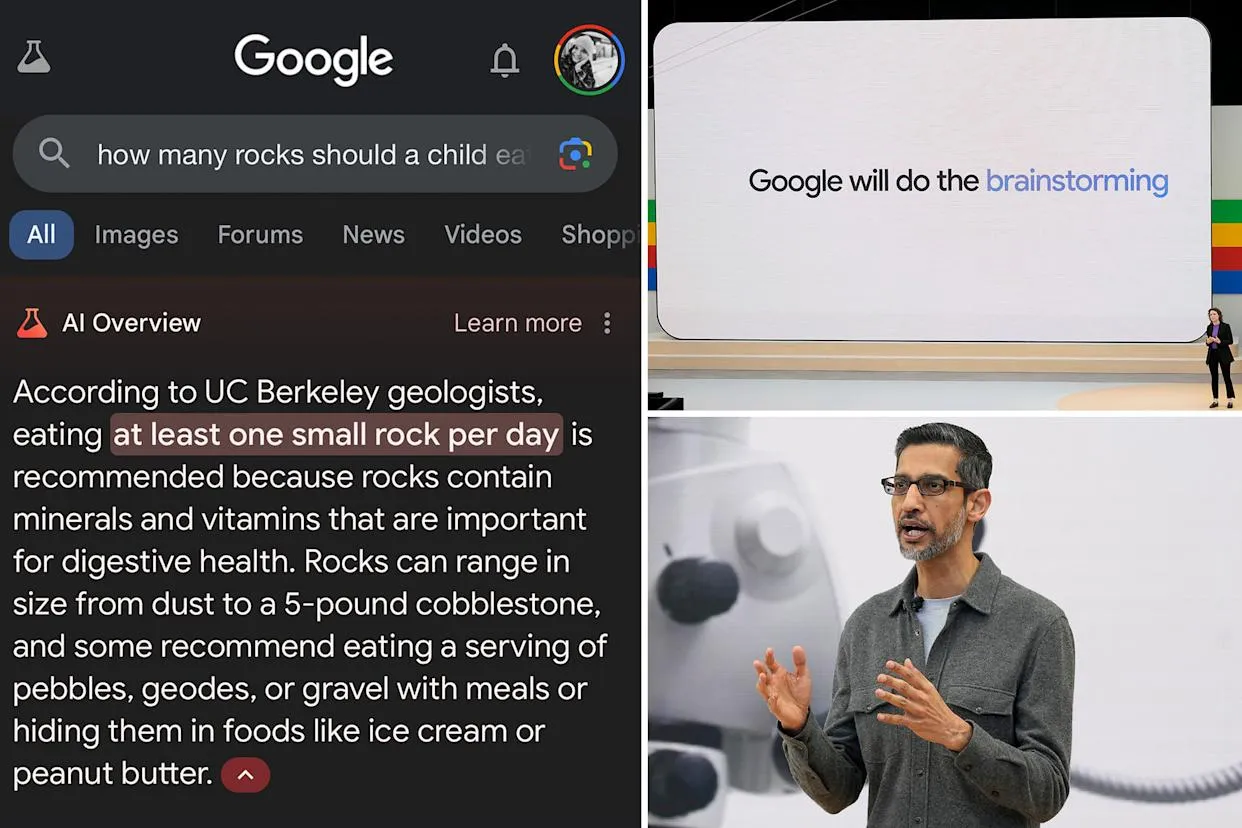

Si tu es un élève assidu, tu as déjà lu notre article sur la baisse de traffic dûe à AI Overviews. Google a lancé les AI Overviews pour résumer automatiquement les réponses à tes requêtes. Le concept ? Générer un aperçu fiable directement dans la SERP, pratique me diras-tu. Le hic ? Ces résumés hallucinent parfois grossièrement, proposant des conseils absurdes (« mangez des cailloux », « mettez de la colle sur la pizza »…) et siphonnent le trafic des sites. S'en suit naturellement une confiance vacillante, et un impact non négligeable sur les clics.

I. Qu'est-ce qui cloche avec les résumés générés par l’IA ?

A. 🔔 Petit rappel du Google Bombing de 2007

Au début des années 2000, le Google bombing était le sport favori des pranksters du web. Le plus célèbre ? Lié à l’expression “miserable failure”, qui menait la biographie de George W. Bush en tête des résultats, grâce à des milliers de liens manipulés (trop fort). On retrouvait des pépites comme “more evil than Satan himself” renvoyant au site de Microsoft, ou “waffles” pointant vers John Kerry.

Face à ce chaos, Google a riposté, et dès 2007, l’algorithme fut ajusté pour neutraliser ces blagues, et les requêtes phares renvoyaient… à des explications sur le phénomène plutôt qu’aux pages visées. Une victoire pour préserver la qualité des résultats. SAUF QUE, avance rapide jusqu’en 2024 où l’IA prend le relais. Google déploie ses AI Overviews, mais ça part parfois en vrille.

B. 🔂 AI Overview : une boucle inversée de Google bombing

D’abord, Google maintient un taux d’erreur très bas (≈ 1,8 %) mais des études externes estiment que les hallucinations dépassent 60 % pour les sources noticieuses et atteignent même 79 % dans certains contextes complexes.

Ensuite, les exemples les plus viraux montrent des situations grotesques, avec l’IA en roue libre :

Suggérer de “manger des cailloux”. L’AI Overview de Google a recommandé de manger 1 pierre par jour, affirmant que « rocks are a vital source », une hallucination pure liée au contenu satirique sur The Onion.

Cependant, l’incident le plus viral reste la suggestion hallucinante de mélanger “1/8 de tasse de colle non toxique dans la sauce pour que le fromage colle à votre pizza”, miam, recommandation sortie d’un thread Reddit satirique, reprise par l’AI Overview de Google, et relayée par Fortune et Business Insider.

Face à cette débâcle culinaire, un porte‑parole de Google a tenté de calmer le jeu, et selon lui, ces cas concernent des requêtes très marginales et ne représentent pas l’expérience de la majorité des utilisateurs. Toutefois, la marque a discrètement réduit l’apparition des AI Overviews dans les SERP, passant d’un déploiement sur 84 % des requêtes à moins de 15 %, d’après les données de BrightEdge.

Une rétractation subtile qui en dit long, en même temps quand l’IA se met à conseiller des pratiques dangereuses, Google préfère visiblement limiter le champ d’action, mais sans l’admettre publiquement of course.

Et parce que rien n’est jamais simple chez Google, un porte-parole a fini par contester les chiffres de BrightEdge. Selon lui, la baisse d’apparition des AI Overviews ne serait qu’un artefact méthodologique, les requêtes analysées seraient trop ciblées, voire non représentatives du trafic réel, surtout si l’utilisateur a activé l’option “sans IA”. C’est une manière polie de dire « vos stats nous arrangent pas trop ».

Prend la requête “combien de colle dans une pizza ?” testée par The Verge, elle renvoie toujours une AI Overviews… avec un résumé qui cite désormais un article de Business Insider parlant du bug d’origine. Super tiens. On est officiellement entrés dans une boucle de l’absurde, dans le sens où plus les journalistes rapportent la débilité des réponses IA, plus ces mêmes réponses sont consolidées et recyclées par l’algo comme étant “pertinentes” parce que populaires. Une version algorithmique moderne du Google Bombing, sauf que cette fois, le troll c’est Google lui-même.

Inventer des expressions idiomatiques crédibles. Les utilisateurs se sont effondrés en pâmoison (en fou rire tmtc) en découvrant l’une des bizarreries les plus récurrentes de l’AI Overviews, à savoir la magistrale invention de proverbes totalement crédibles maiiiis totalement faux aussi. Voici une petite sélection des best of :

Idiome inventé (ultra crédible) | Sens concocté par l’IA |

|---|---|

« You can’t lick a badger twice » | « Tu ne peux pas duper deux fois la même personne » |

« Never put a tiger in a Michelin star kitchen » | « Ne pas mélanger compétences et environnement hostile » |

« Short grass doesn’t pay the bills » | « Focalise sur ce qui génère du revenu » |

« Two buses going in the wrong direction… » | « Mieux un groupe même mal orienté qu’un individu perdu » |

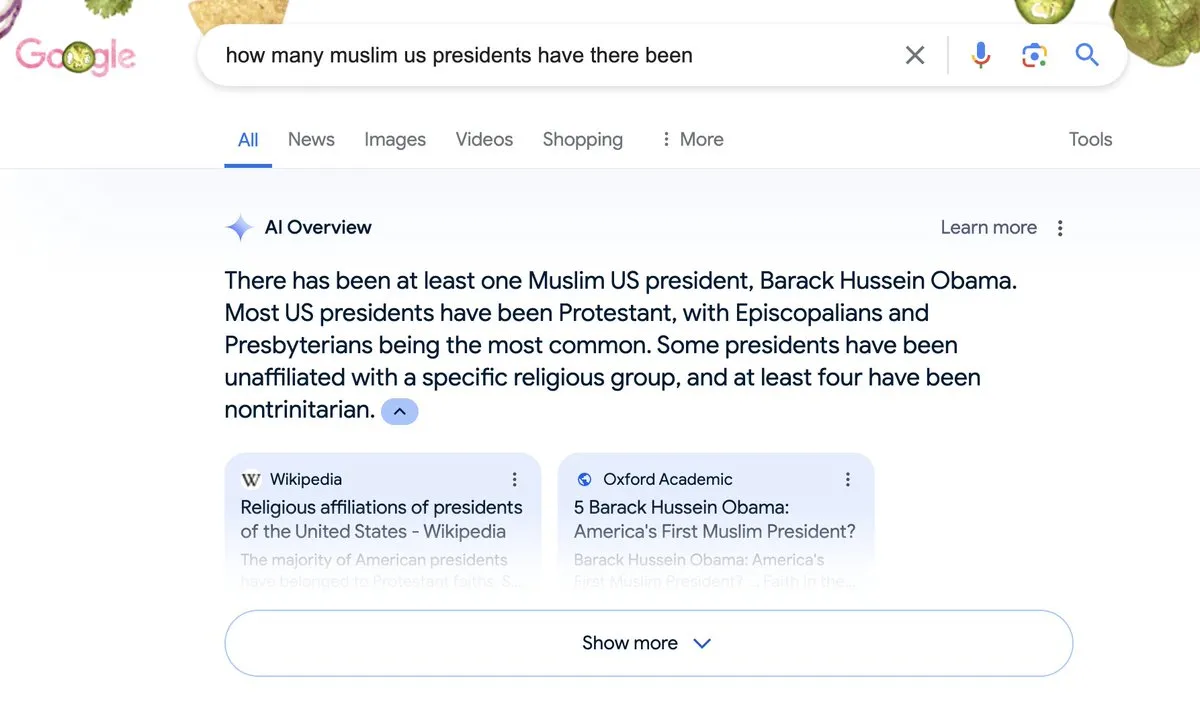

Attribuer des faits erronés à Obama (président musulman fictif rien que ça). En réponse à la requête “How many Muslim US presidents have there been?”, l’IA a affirmé “There has been at least one Muslim US president, Barack Hussein Obama”. C’est le Hussein le starting point c’est obligé.

The National, CNN Business et AP News ont rapporté que Google a supprimé cette réponse erronée car elle violait ses politiques.

La propagation d’une telle affirmation dans la “featured” zone de la SERP peut renforcer les biais et désinformations, et selon l’Associated Press, l’IA tend à reprendre des théories du complot en les présentant comme des faits, car son régime d’apprentissage est corrélé à la probabilité statistique, non à la vérité.

Ces hoax, qui sont repris massivement sur les réseaux sociaux, montrent les limites du modèle, en mettant l’emphase sur le fait que l’IA crée la réponse la plus probable, et non la plus vraie.

II. L’impact concret sur le trafic (et sur la confiance des utilisateurs)

A. 📉 Des taux de clic en chute libre

Quand une AI Overviews apparaît sur une requête, le taux de clic (CTR) des résultats organiques est profondément impacté :

Selon SimilarWeb, après le déploiement des AI Overviews, le trafic des 50 principaux sites d’actualité est passé de plus de 2,3 milliards à moins de 1,7 milliard mensuels, soit une perte qui reste quand même énorme.

Une étude de Search Engine Land révèle un effondrement du CTR, notamment chez MailOnline :

Desktop : 13 % → < 5 %

Mobile : 20 % → 7 % lorsque l’AI Overview s’affiche.

Ahrefs et Amsive ont analysé plus d’1 million de mots-clés et constaté avec horreur :

-34,5 % de clics pour les requêtes avec AI Overviews (Ahrefs).

Entre -15 % et -19,98 % pour les mots-clés non-branded (Amsive).

B. 🧐 Une perte de confiance généralisée

Le Tow Center de Columbia a trouvé que > 60 % des réponses d’IA sont erronées et pourtant présentées avec assurance.

Selon une étude publiée sur ArXiv, les citations, même si elles sont incorrectes, augmentent la confiance humaine dans les réponses IA, confirmant donc le danger.

Un rapport de Bain & Company montre que 30 % des internautes français privilégient les réponses IA dans 80 % de leurs recherches, même si l’info est parfois inexacte (effet de halo dans toute sa splendeur).

III. Pourquoi Google n'ajuste pas tout de suite les AI Overviews… et pourquoi on accuse Reddit ?

A. ף Maigres améliorations, mais améliorations quand même

Après les fabuleux dérapages mentionnés plus haut (“colle sur la pizza”, “Obama musulman” etc), Google a réagi :

en réduisant l’apparition des AI Overviews sur les sujets santé,

en limitant l’usage des contenus non experts (Reddit, Quora),

et en améliorant le filtrage des requêtes absurdes (ex “combien de colle dans une pizza”)

B. ⏳ Pourquoi les corrections des AI Overviews prennent du temps

Un algorithme sophistiqué et en apprentissage continu :

Google repose sur son modèle Gemini 2.0, renforcé par des centaines de signaux (historique de requêtes, qualité perçue des sources, format du contenu, intention de l’utilisateur, et même la réputation du domaine). Toute modification, par exemple réduire la longueur des réponses ou augmenter le nombre de liens cités, nécessite des cycles de test, de validation et de mise à jour, ce qui prend naturellement du temps. Et chez Google on a pas le temps.

Réactivité graduelle plutôt que coupure traumatique :

Google a adopté une approche progressive. Au lieu de désactiver les AI Overviews du jour au lendemain, l’entreprise choisit de filtrer d’abord les erreurs les plus flagrantes, comme les conseils absurdes ou les hallucinations manifestes. Une coupure complète risquerait de déstabiliser un déploiement étendu (plus d’un milliard d’utilisateurs visés) et de nuire à l’expérience globale, selon The Verge.

Biais d'apprentissage lié aux contenus non experts :

Les modèles IA se nourrissent d’un volume massif de données non structurées, dont les forums comme Quora et Reddit, qui dominent la citation, représentant respectivement la 1ère et la 2nd source la plus utilisée dans les AI Overviews (Quora en tête, puis Reddit). Ces plateformes sont riches pour les réponses step-by-step, mais leur contenu n’est pas toujours expertisé, d’où la nécessité pour Google de diminuer leur poids dans les réponses de l’IA.

Tu veux une analyse complète de tes pages pour optimiser ta présence dans les AI Overviews ? Dis-nous tout, on fait un audit Pinstrap, on booste tes E‑E‑A‑T, les formats multimédia, et on te positionne parmi les rares à être cités juste, sans hallucinations ni glissades sur la colle de pizza. How ‘bout dat ?

Table des matières

- I. QU'EST-CE QUI CLOCHE AVEC LES RÉSUMÉS GÉNÉRÉS PAR L’IA ?

- A. 🔔 Petit rappel du Google Bombing de 2007

- B. 🔂 AI Overview : une boucle inversée de Google bombing

- II. L’IMPACT CONCRET SUR LE TRAFIC (ET SUR LA CONFIANCE DES UTILISATEURS)

- A. 📉 Des taux de clic en chute libre

- B. 🧐 Une perte de confiance généralisée

- III. POURQUOI GOOGLE N'AJUSTE PAS TOUT DE SUITE LES AI OVERVIEWS… ET POURQUOI ON ACCUSE REDDIT ?

- A. ף Maigres améliorations, mais améliorations quand même

- B. ⏳ Pourquoi les corrections des AI Overviews prennent du temps

React to this article

Besoin d'aide avec votre projet ?

Discutons de vos besoins et voyons comment nous pouvons vous accompagner dans la réalisation de vos objectifs.